Многие из вас наверняка в курсе, что с весны 2010 года

Google начал учитывать при ранжировании результатов поисковой выдачи новый фактор —

скорость загрузки страниц сайта. И хоть релевантность страницы, по заявлению сотрудников Google, осталась важнейшим фактором, но и скорости загрузки был придан определённый "вес". В этом материале я попробую поделиться личным опытом и соображениями на этот счёт, что в конечном итоге может помочь вам в продвижении вашего сайта.

Для начала несколько мыслей о самом алгоритме вычисления скорости загрузки страниц сайта Гуглом. По заверениям самого Google, в подсчёте этой самой скорости используется несколько источников. Так, например, в панели

Google Webmaster есть как минимум два источника, отражающих этот показатель —

Статистика сканирования и

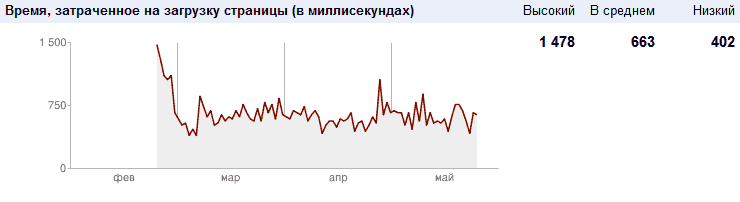

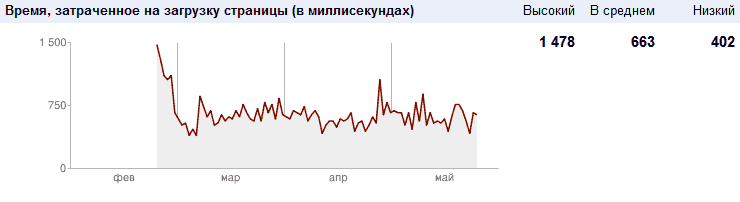

Эффективность сайта. Последняя, судя по всему, использует данные, передаваемые пользователями — например, через какой-либо тулбар наподобии Alexa Toolbar. Первый же имеет график, отражающих скорость загрузки страниц поисковым ботом Google.

Я считаю, что этот показатель ( Статистика сканирования ) является основным и наиболее весомым, так как с точки зрения логики поисковой системы данные, отправляемые самими пользователями, не могут быть объективными — разные браузеры, разная скорость соединения, разные географические положения — всё это может существенно влиять на скорость загрузки страницы у пользователя. Было бы нелогично полагаться на них при вычислении скорости загрузки страниц сайта. И это подтверждается личным опытом.

Теперь немного об этом самом личном опыте. В начале существования сайта он был расположен на крупном и авторитетном хостинге — относительно быстром, но всё же недостаточно быстром для того, чтобы вызывать удовлетворение. В отдельные неудачные моменты скорость загрузки страниц сайта ботом Гугла, судя по статистике Панели Вебмастера, доходила до

7-8 секунд, что непростительно много. Соответственно и средняя скорость загрузки страницы плавала в районе

4 секунд, что также слишком много.

В какой-то момент хостинг было решено сменить, и сайт переехал на специализирующийся по Drupal хостинг, что немедленно очень положительно сказалось на скорости загрузки — она сразу упала в несколько раз и в среднем страницы начали загружаться за 1-1,5 секунды ( опять-таки по статистике сканирования Панели Вебмастера ). Уже тогда стало заметно, что позиции блога в поисковой выдаче начали улучшаться, хотя никакой другой работы по оптимизации не проводилось — всё было сделано в самом начале и с тех пор существенно в этом плане ничего не менялось.

Затем хостер заменил сервер, на котором был расположен мой сайт, на более мощный, и сайт начал "летать" — скорость загрузки увеличилась ещё в 2 раза и составила около

400-600 мс, что является очень и очень достойным результатом. На данный момент прошло уже почти 3 месяца с момента замены сервера, и средняя скорость загрузки страниц сайта упала до 660 мс, продолжая снижаться — просто бальзам на душу. К слову, в статистике сканирования учитываются данные за последние три месяца. Также стоит оговориться, что

обязательным условием высокой скорости загрузки страниц сайта является использование какого-либо механизма кеширования для анонимных пользователей ( каким и является по сути бот Гугла ) — страница не должна генерироваться в момент запроса бота, она должна только отдаваться ему в почти готовом виде — иначе высокой скорости загрузки добиться будет значительно труднее. Благо, в Drupal такой механизм есть и работает он исправно.

А теперь о результатах. В итоге за полгода средняя скорость загрузки страниц сайта упала с 4 секунд до 0,6 секунд. Блог ощутимо прибавил в результатах поисковой выдачи, забравшись гораздо выше, чем ему по идее было положено — так, если в начале по достаточно популярным запросам крупные порталы и официальные сайты производителей легко обходили его, то теперь зачастую блогу удаётся расположиться даже выше них (!). Объяснить такой взлёт только повышением "траста" было бы не совсем корректно — я всё же уверен, что подобный рост напрямую связан с улучшением показателей скорости загрузки страниц сайта ботом Гугла. Так, например, мною был отмечен скачок вверх после того, как показатель средней скорости загрузки опустился

ниже 0,8 сек ( 800 мс ) — многие запросы резко прибавили в выдаче, от 5 до 10 позиций вверх и больше ( причём и изначально они были на 10-20 позициях, так что конкуренция была ).

Вывод: не претендуя на истину в последней инстанции, теперь я твёрдо уверен, что скорость загрузки сайта оказывает существенное и заметное влияние на позиции сайта в поисковой выдаче. Оптимизация контента сайта и его производительности должны идти рука об руку — если вы "закрыли" весь дублирующийся контент в robots.txt, привели в порядок теги H1 — H6 в шаблоне, упорядочили теги TITLE и метатеги, то следующим этапом должна стать оптимизация производительности сайта — не в последнюю очередь в плане выбора хорошего хостера, так как "железо", на котором крутится сайт, также имеет большое значение.

Думаю, стоит взять за ориентир среднюю скорость загрузки страниц сайта в

0,8 секунд и менее — именно такая скорость в Панели Вебмастера Google в пункте меню Эффективность сайта обозначена как граница "быстрого" сайта. И добиваться этого показателя нужно настойчиво — результат не заставит себя ждать. При прочих равных высокая скорость работы может дать серьёзное преимущество вашему сайту, да и при не-равных "прочих" это сыграет на руку и позволит расположиться повыше в резльтатах поиска.

Многие из вас наверняка в курсе, что с весны 2010 года Google начал учитывать при ранжировании результатов поисковой выдачи новый фактор — скорость загрузки страниц сайта. И хоть релевантность страницы, по заявлению сотрудников Google, осталась важнейшим фактором, но и скорости загрузки был придан определённый "вес". В этом материале я попробую поделиться личным опытом и соображениями на этот счёт, что в конечном итоге может помочь вам в продвижении вашего сайта.

Многие из вас наверняка в курсе, что с весны 2010 года Google начал учитывать при ранжировании результатов поисковой выдачи новый фактор — скорость загрузки страниц сайта. И хоть релевантность страницы, по заявлению сотрудников Google, осталась важнейшим фактором, но и скорости загрузки был придан определённый "вес". В этом материале я попробую поделиться личным опытом и соображениями на этот счёт, что в конечном итоге может помочь вам в продвижении вашего сайта.

Полезная статья

Если честно говорить от хостинга и зависит время загрузки сайта…. Ни какие плагины кэширования, чистка кода, уменьшения размера загруженных файлов не спасет уже проверял…

И да можно поинтересоваться ценами в месяц на хостенге который стоит твой блог.

Не со всем согласен. Ваше утверждение справедливо только в том случае, если хостинг действительно "никакой". Тогда понятное дело — оптимизируй, не оптимизируй, а толку будет не много, так как тормозить будет ещё до обращения непосредственно к движку сайта. Перегруженый/неоптимизированный сервер хостера может тормозить даже на отдаче статичных HTML-файлов, что уж тут говорить о генерации страничек "на лету" через PHP и MySQL. Тем не менее, если переезжать не хочется — даже на таком месте можно попытаться улучшить ситуацию в меру своих возможностей. Конечно, многое зависит и от движка сайта — разные CMS по-разному поддаются оптимизации, хотя в целом принципы везде одни и те же и могут быть адаптированы для любого движка.

Говоря непосредственно о моём блоге — на старом хостинге страницы генерировались за 1,8 — 4 секунды, при этом сервер мог начать их "отдавать" только после завершения генерации, то есть до полной загрузки страницы уходило 8-12 секунд, что слишком много. На новом сервере при тех же настройках время генерации сократилосьдо 0,8 — 1,2. что было заметно даже "на глаз". После этого я уже конкретно начал интересоваться способами оптимизации и практически безболезннено нашёл способы снизить даже это число до минимума. По сути сейчас анонимным посетителям ( коих большинство, ~99% ) страницы отдаются в кешированном виде как статичные HTML-страницы за 0,3 — 0,4 секунды, без обращения к движку блога. Но это я уже повторяюсь, вроде было написано об этом в самой статье.

Хостинг, на котором крутится этот блог, обходится мне в 100 рублей в месяц — сижу на самом младшем тарифе.

Ахах я сейчас умру как я протуп… с хостингом мало что он как бы грузится по разному то 5 сек то 30 -_-, но еще и оплата там вроде уже не помню 250руб в месяц что ли… но суть беды в том, что я его оплатил на год вперед а только потом заметил что блог достаточно медленно открывается несмотря на всю мою проделанную работу… даже платный плагин кэширования не спас. Теперь придется ждать год увы.

скажи пож-ста какой хостинг был и на каком сейчас

Был hoster.by, сейчас it-patrol.ru

Ваш сайт действительно шустрый, конечно от сервака тоже многое зависит! Но часто бывает до смешного - нарвешься на полезную статью об оптимизации, тестируешь сам блог, на котором статья, а скорость говно.

У меня вопрос, если не секрет, вы какой дрюпал-плагин настраивали дял кеша или все делали руками?